Testi tehisintellekti OMA veebisaidil 60 sekundiga

Vaata, kuidas meie tehisintellekt analüüsib koheselt sinu veebisaiti ja loob personaliseeritud vestlusroboti - ilma registreerimiseta. Sisesta lihtsalt oma URL ja jälgi, kuidas see toimib!

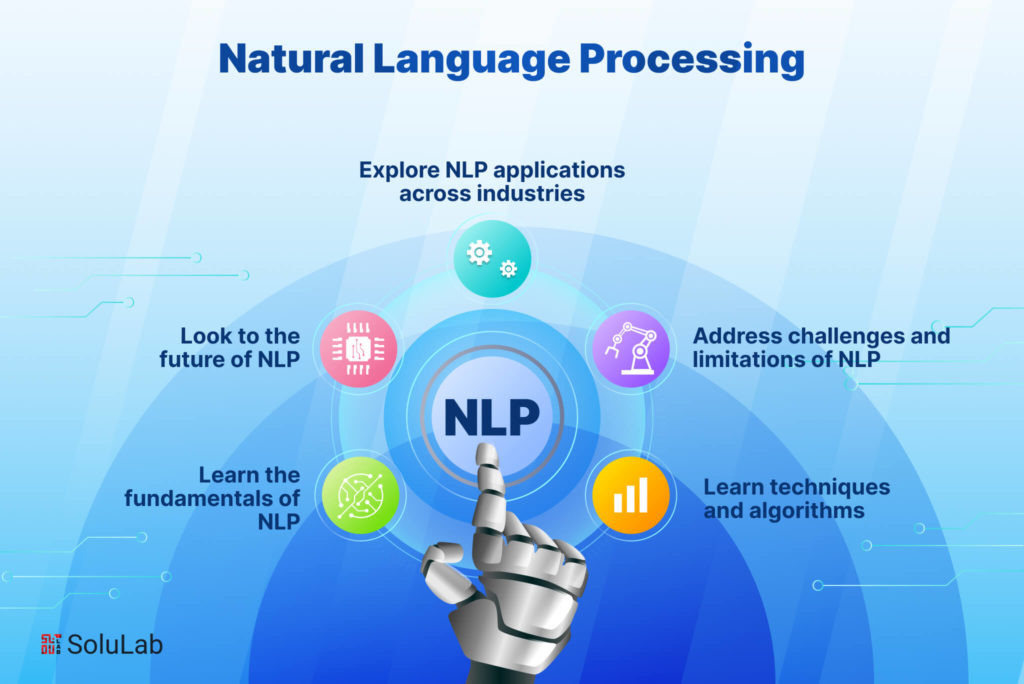

Sissejuhatus: NLP arendamise arenev maastik

Viimase aasta jooksul on NLP-tehnoloogias toimunud märkimisväärseid edusamme – alates tõhusamatest peenhäälestusmeetoditest kuni multimodaalsete võimalusteni, mis ühendavad teksti teiste andmetüüpidega. Tööaja efektiivsus on muutunud üha olulisemaks, kuna üha rohkem NLP töökoormusi kolib servaseadmetesse ja tarbijariistvarasse. Samal ajal on spetsialiseeritud valdkonnavõimalused laienenud, et teenindada enneolematu täpsusega valdkondi alates tervishoiust kuni õigusteenusteni.

Olenemata sellest, kas ehitate vestlusagenti, analüüsite klientide tagasisidet, ammutate dokumentidest teavet või loote sisu genereerimise tööriistu, õige NLP-teegi valimine võib teie projekti edu oluliselt mõjutada. See juhend uurib seitset kõige mõjukamat NLP-teeki 2025. aastal, võrreldes nende tugevusi, piiranguid ja ideaalseid kasutusjuhtumeid, et aidata teil teha teadlikke otsuseid oma järgmise arendusprojekti kohta.

1. Kallistavad näotransformaatorid 6.0: terviklik ökosüsteem

Põhifunktsioonid ja täiustused

Uusim versioon sisaldab mitmeid mängu muutvaid funktsioone:

Tõhus peenhäälestusraamistik: uus EFT-moodul vähendab oluliselt arvutusnõudeid vundamendimudelite kohandamiseks konkreetsete ülesannetega. Mudeleid, mis varem nõudsid peenhäälestamiseks mitut GPU-d, saab nüüd kohandada tarbija riistvarale minimaalse jõudluse kompromissiga.

Multimodaalsed torujuhtmed: Transformers pakub nüüd rakenduste loomiseks sujuvaid torujuhtmeid, mis ühendavad sujuvalt tekstianalüüsi pildi, heli ja isegi video mõistmisega – ideaalne kontekstiteadlikumate rakenduste loomiseks.

Ettevõtlustaseme juurutamistööriistad: uus juurutamise tööriistakomplekt lihtsustab mudelite viimist uurimistööst tootmisse, optimeerides erinevate riistvaraobjektide jaoks, serveriklastritest mobiilseadmeteni.

Domeeni spetsialiseerumispaketid: konkreetsete tööstusharude (nt tervishoid, juriidiline valdkond ja rahandus) eelkonfigureeritud sätted ja mudelid võimaldavad arendajatel alustada üldiste mudelite asemel domeenile optimeeritud alustest.

Miks arendajatele see meeldib?

Trafod domineerivad jätkuvalt, kuna see loob erakordse tasakaalu juurdepääsetavuse ja tipptasemel võimaluste vahel. Hästi dokumenteeritud API muudab uustulnukate jaoks NLP täiustatud funktsioonide rakendamise lihtsaks, samas kui ulatuslikud kohandamisvalikud rahuldavad kogenud ML-i inseneride vajadusi.

Hugging Face'i ümbritsev elav kogukond tähendab ka seda, et lahendused levinud probleemidele on tavaliselt vaid foorumiotsingu kaugusel, mis vähendab oluliselt arendusaega. Kuna Model Hubis on nüüd saadaval üle 75 000 eelkoolitatud mudeli, saavad arendajad sageli leida spetsiaalseid mudeleid, mis vastavad täpselt nende kasutusjuhtude nõuetele, alustamata nullist.

Ideaalsed kasutusjuhtumid

Hugging Face Transformers 6.0 on suurepärane:

Uurimisprojektid, mis nõuavad kiiret katsetamist erinevate mudeliarhitektuuridega

Tootmisrakendused, mis vajavad nüüdisaegset keeleoskust

Meeskonnad, kes soovivad kasutada kogukonna teadmisi ja ressursse

Projektid, mis nõuavad spetsiifilisi valdkonnateadmisi (tervishoid, õigus, rahandus)

Multimodaalseid võimalusi vajavad rakendused

Kaalutlused

Kuigi Transformers on endiselt kõige mitmekülgsem valik, ei ole see juurutamiseks alati kõige ressursitõhusam valik. Mõned arendajad teatavad, et üldistatud arhitektuur sisaldab üldkulusid, mida spetsialiseeritud raamatukogud väldivad. Lisaks tähendab kiiresti arenev koodibaas aeg-ajalt peamiste versioonide vahelisi muudatusi.

2. SpaCy 4.0: tootmisvalmis tõhusus

Põhifunktsioonid ja täiustused

SpaCy 4.0 toob tabelisse olulisi täiustusi:

Trafode integreerimine: trafode uuendatud torujuhtme komponendid töötavad nüüd koos uusimate mudelitega, säilitades samal ajal SpaCy tõhusa töötlemisarhitektuuri.

Täiustatud mitmetöötlus: uued paralleelse töötlemise võimalused pakuvad peaaegu lineaarset skaleerimist dokumentide töötlemise ülesannete jaoks, muutes SpaCy sobivaks tohutute tekstikogude paketttöötluseks.

Laiendatud struktureeritud ennustamine: lisaks nimega olemi tuvastamisele ja sõltuvuse sõelumisele pakub SpaCy nüüd täiustatud tuge kohandatud struktureeritud ennustusülesannetele paindlikuma annotatsiooni- ja koolitusraamistiku kaudu.

Leanim käitusaja nõuded: vaatamata suurenenud võimalustele saavad tuumatöötluskonveierid nüüd töötada märkimisväärselt väiksema mälumahuga – see on ressurssidega piiratud keskkondades juurutamiseks ülioluline.

Täiustatud reeglimootor: mustrite sobitamise süsteem on täielikult uuendatud, pakkudes võimsamaid väljendeid, parandades samal ajal sobitamise kiirust kuni 300%.

Miks arendajad selle valivad?

SpaCy on jätkuvalt tootmissüsteemide eelistatud valik, kuna see pakub arendajasõbraliku API abil tööstuslikku jõudlust. Läbimõeldult kavandatud objektorienteeritud arhitektuur muudab selle hõlpsaks integreerimise suurematesse rakendustesse, säilitades samal ajal ühtlase jõudluse.

Uus "SpaCy Projects" raamistik on lihtsustanud ka NLP-torude otspunktide pakkimist ja juurutamist, võimaldades meeskondadel standardiseerida oma arendustöövooge katsetamisest tootmiseni.

Ideaalsed kasutusjuhtumid

SpaCy 4.0 sobib suurepäraselt:

Suure läbilaskevõimega tekstitöötlussüsteemid

Tootmiskeskkonnad, kus usaldusväärsus ja prognoositavus on üliolulised

Rakendused, mis nõuavad tööstuslikult tugeva nimega olemi tuvastamist ja suhete eraldamist

Juurutuspiirangutega projektid (mälu, töötlemisvõimsus)

Meeskonnad, kes vajavad nii klassikalist NLP-võimekust kui ka kaasaegseid neuraalseid lähenemisviise

Kaalutlused

Kuigi SpaCy on teinud suuri edusamme trafomudelite kaasamisel, ei paku see endiselt sama laia tipptasemel uurimistöö rakendusi kui Hugging Face. Lisaks leiavad mõned arendajad, et selle arvamuslik arhitektuur on väga kohandatud uurimisrakenduste jaoks vähem paindlik.

3. Sidus SDK: API-First Language Intelligence

Peamised omadused ja täiustused

Cohere platvorm pakub mitmeid veenvaid võimalusi:

Command ja Command-R mudelid: need mudelid on suurepärased konkreetsete juhiste järgimisel ja nüansirikaste taotluste mõistmisel, mistõttu on need ideaalsed tööriistade loomiseks, mis vastavad täpselt kasutaja päringutele.

Manustamismudelid: uusima põlvkonna manustamismudelid loovad märkimisväärselt täpseid semantilisi esitusi, edestades oluliselt varasemaid lähenemisviise otsingu- ja klassifitseerimisülesannetes.

Ettevõtte kohandamine: spetsiifiliste vajadustega organisatsioonidele pakub Cohere nüüd kohandamisvõimalusi, mis kohandavad nende põhimudeleid spetsialiseeritud valdkondadega ilma massiivseid treeningandmekogumeid nõudmata.

Mitmekeelne tugi: tugevad võimalused enam kui 100 keeles võimaldavad globaalseid rakendusi ilma iga keele jaoks eraldi mudeleid vajamata.

Vastutustundlikud tehisintellekti kontrollid: sisseehitatud turvafiltrid ja eelarvamuste tuvastamine aitavad arendajatel luua süsteeme, mis vastavad üha olulisematele eetilistele standarditele.

Miks arendajad selle valivad?

Cohere SDK on populaarsust kogunud peamiselt seetõttu, et see vähendab oluliselt keerukate masinõppe võimaluste rakendamise takistusi. Arendajad, kellel puudub masinõppe kogemus, saavad rakendustele minimaalse koodiga lisada täiustatud keeleoskuse, omades samal ajal vajadusel mudeli käitumise üle täpset kontrolli.

API-keskne lähenemine tähendab ka seda, et meeskonnad ei pea muretsema infrastruktuuri haldamise ega uusimate teadussaavutustega kursis olemise pärast – Cohere tegeleb nende aspektidega, võimaldades arendajatel keskenduda oma rakenduse loogikale.

Ideaalsed kasutusjuhud

Cohere SDK sobib suurepäraselt:

Startup-firmadele ja meeskondadele ilma spetsiaalse masinõppe infrastruktuurita

Rakendused, mis peavad kiiresti skaleeruma ilma mudeli juurutamist haldamata

Projektid, mis vajavad ettevõtte tasemel töökindlust ja tuge

Mitmekeelsed rakendused, mis teenindavad globaalseid turge

Kasutusjuhud, kus vastutustundlikud tehisintellekti tavad on prioriteediks

Kaalutlused

Cohere'i peamine kompromiss on see, et arendajad sõltuvad kolmanda osapoole teenusest, selle asemel et käitada mudeleid oma infrastruktuuris. See tekitab potentsiaalseid probleeme andmete privaatsuse, teenuste kättesaadavuse ja pikaajalise hinnastabiilsuse osas. Mõned arendajad märgivad ka, et API-põhine lähenemine on küll mugav, kuid piirab mõnikord paindlikkust võrreldes mudeli sisemistele osadele otsese juurdepääsuga.

4. PyTorch NLP (torchtext 3.0): teadlase valik

Põhifunktsioonid ja täiustused

Uusim versioon sisaldab mitmeid olulisi uuendusi:

Trafoarhitektuuride loomulik tugi: tähelepanumehhanismide ja trafoplokkide esmaklassilised rakendused muudavad kohandatud arhitektuuride rakendamise lihtsamaks.

Optimeeritud andmetöötluse torujuhtmed: uued vektoriseeritud tekstitöötlustoimingud kasutavad kaasaegseid protsessoreid ja GPU-sid tõhusamalt, kiirendades järsult eeltöötlusetappe.

Täiustatud ülekandmise õpperaamistik: täiustatud API muudab eelkoolitatud mudelite kohandamise uute ülesannetega lihtsaks, säilitades samal ajal täpse kontrolli koolitusprotsessi üle.

Kvantimis- ja pügamistööriistad: mudeli tihendamise sisseehitatud võimalused võimaldavad teadlastel vähendada mudeli suurust ja järeldusaega ilma jõudluse liigse halvenemiseta.

Täiustatud partiitöötlus: Muutuva pikkusega jadade nutikamad komplekteerimisstrateegiad tagavad GPU tõhusama kasutamise treeningu ajal.

Miks teadlased ja arendajad selle valivad?

PyTorch NLP on endiselt eelistatud valik teadusuuringute ja erirakenduste jaoks, kuna see pakub maksimaalset paindlikkust kasutatavust ohverdamata. Vajalik programmeerimisstiil ühtib enamiku arendajate mõtteviisiga, muutes mudelite silumise ja uudsete lähenemisviisidega katsetamise lihtsamaks.

Sujuv integratsioon laiema PyTorchi ökosüsteemiga tähendab ka seda, et üldise süvaõppe edusammud (nagu optimeerimistehnikad või koolitusmeetodid) on koheselt rakendatavad ka NLP ülesannete puhul.

Ideaalsed kasutusjuhtumid

PyTorch NLP sobib kõige paremini:

Uudseid arhitektuure või koolitusviise uurivad uurimisprojektid

Rakendused, mis nõuavad kohandatud mudeli käitumist, pole kõrgema taseme teekides saadaval

Hariduskontekstid, kus mudeli sisemuse mõistmine on oluline

Projektid, kus on vaja integreerimist arvutinägemise või muude meetoditega

Olukorrad, mis nõuavad treeningprotsessi maksimaalset kontrolli

Kaalutlused

PyTorch NLP paindlikkusega kaasneb järsem õppimiskõver ja suurem vastutustundlikkus. Arendajad peavad tegema rohkem arhitektuurilisi otsuseid ja juurutama rohkem komponente nullist, võrreldes kõrgema taseme raamatukogudega. Lisaks nõuavad mõned tootmise optimeerimise funktsioonid nõuetekohaseks rakendamiseks täiendavat tööd.

Testi tehisintellekti OMA veebisaidil 60 sekundiga

Vaata, kuidas meie tehisintellekt analüüsib koheselt sinu veebisaiti ja loob personaliseeritud vestlusroboti - ilma registreerimiseta. Sisesta lihtsalt oma URL ja jälgi, kuidas see toimib!

5. JAX NLP (FLAX/Prax): jõudlus mastaabis

Meta Description: Discover the most powerful and versatile natural language processing libraries of 2025 that are revolutionizing how developers build intelligent text applications.

Introduction: The Evolving Landscape of NLP Development

Natural Language Processing (NLP) continues to transform how we interact with technology in 2025. As the demand for sophisticated language understanding capabilities grows across industries, developers need powerful, efficient, and accessible tools to build applications that can genuinely understand and generate human language.

The past year has seen remarkable advancements in NLP technology—from more efficient fine-tuning approaches to multimodal capabilities that bridge text with other data types. Runtime efficiency has become increasingly important as more NLP workloads move to edge devices and consumer hardware. Meanwhile, specialized domain capabilities have expanded to serve industries from healthcare to legal services with unprecedented accuracy.

Whether you're building a conversational agent, analyzing customer feedback, extracting insights from documents, or creating content generation tools, choosing the right NLP library can dramatically impact your project's success. This guide examines the seven most impactful NLP libraries of 2025, comparing their strengths, limitations, and ideal use cases to help you make an informed decision for your next development project.

1. Hugging Face Transformers 6.0: The Comprehensive Ecosystem

Hugging Face Transformers has cemented its position as the go-to library for accessing state-of-the-art NLP models, and the 6.0 release takes its capabilities to new heights. Far more than just a model repository, Transformers has evolved into a comprehensive ecosystem that covers the entire NLP development lifecycle.

Key Features and Improvements

The latest version introduces several game-changing features:

Efficient Fine-tuning Framework: The new EFT module significantly reduces the computational requirements for adapting foundation models to specific tasks. Models that previously required multiple GPUs for fine-tuning can now be customized on consumer hardware with minimal performance trade-offs.

Multimodal Pipelines: Transformers now offers streamlined pipelines for building applications that seamlessly combine text analysis with image, audio, and even video understanding—perfect for creating more context-aware applications.

Enterprise-Grade Deployment Tools: The new deployment toolkit simplifies moving models from research to production with automated optimization for different hardware targets, from server clusters to mobile devices.

Domain Specialization Packs: Pre-configured settings and models for specific industries like healthcare, legal, and finance allow developers to start with domain-optimized foundations rather than generic models.

Why Developers Love It

Transformers continues to dominate because it strikes an exceptional balance between accessibility and cutting-edge capabilities. The well-documented API makes it straightforward for newcomers to implement advanced NLP features, while the extensive customization options satisfy the needs of experienced ML engineers.

The vibrant community surrounding Hugging Face also means solutions to common problems are usually just a forum search away, significantly reducing development time. With over 75,000 pre-trained models now available in the Model Hub, developers can often find specialized models that closely match their use case requirements without starting from scratch.

Ideal Use Cases

Hugging Face Transformers 6.0 excels for:

Research projects requiring quick experimentation with different model architectures

Production applications needing state-of-the-art language understanding

Teams wanting to leverage community knowledge and resources

Projects requiring specialized domain knowledge (healthcare, legal, finance)

Applications needing multimodal capabilities

Considerations

While Transformers remains the most versatile option, it's not always the most resource-efficient choice for deployment. Some developers report that the generalized architecture introduces overhead that specialized libraries avoid. Additionally, the rapidly evolving codebase means occasional breaking changes between major versions.

2. SpaCy 4.0: Production-Ready Efficiency

SpaCy has long been the workhorse of production NLP systems, and version 4.0 reinforces this position while expanding its capabilities to incorporate transformer-based models more seamlessly than ever. The library's focus on production efficiency combined with state-of-the-art accuracy makes it ideal for systems that need reliability at scale.

Key Features and Improvements

SpaCy 4.0 brings significant enhancements to the table:

Transformer Integration: The updated transformer pipeline components now work natively with the latest models while maintaining SpaCy's efficient processing architecture.

Enhanced Multiprocessing: New parallel processing capabilities provide near-linear scaling for document processing tasks, making SpaCy suitable for batch processing enormous text collections.

Expanded Structured Prediction: Beyond named entity recognition and dependency parsing, SpaCy now offers enhanced support for custom structured prediction tasks through a more flexible annotation and training framework.

Leaner Runtime Requirements: Despite the increased capabilities, core processing pipelines can now run with significantly reduced memory footprints—crucial for deployment in resource-constrained environments.

Improved Rule Engine: The pattern matching system has been completely overhauled, offering more powerful expressions while improving match speed by up to 300%.

Why Developers Choose It

SpaCy continues to be the preferred choice for production systems because it provides industrial-strength performance with a developer-friendly API. The thoughtfully designed object-oriented architecture makes it easy to integrate into larger applications while maintaining consistent performance.

The new "SpaCy Projects" framework has also simplified the packaging and deployment of end-to-end NLP pipelines, allowing teams to standardize their development workflows from experimentation to production.

Ideal Use Cases

SpaCy 4.0 is perfect for:

High-throughput text processing systems

Production environments where reliability and predictability are crucial

Applications requiring industrial-strength named entity recognition and relation extraction

Projects with deployment constraints (memory, processing power)

Teams that need both classical NLP capabilities and modern neural approaches

Considerations

While SpaCy has made great strides in incorporating transformer models, it still doesn't offer the same breadth of cutting-edge research implementations as Hugging Face. Additionally, some developers find its opinionated architecture less flexible for highly customized research applications.

3. Cohere SDK: API-First Language Intelligence

Cohere has emerged as a powerful alternative in the NLP ecosystem with its SDK that focuses on delivering production-ready language intelligence through a streamlined API. Rather than requiring developers to manage model deployment themselves, Cohere provides access to continuously updated, state-of-the-art models via simple API calls.

Key Features and Improvements

The Cohere platform offers several compelling capabilities:

Command and Command-R Models: These models excel at following specific instructions and understanding nuanced requests, making them ideal for building tools that respond precisely to user queries.

Embed Models: The latest generation embedding models create remarkably accurate semantic representations, significantly outperforming previous approaches in retrieval and classification tasks.

Enterprise Customization: For organizations with specific needs, Cohere now offers customization options that adapt their core models to specialized domains without requiring massive training datasets.

Multilingual Support: Robust capabilities across 100+ languages enable global applications without needing separate models for each language.

Responsible AI Controls: Built-in safety filters and bias detection help developers create systems that meet increasingly important ethical standards.

Why Developers Choose It

The Cohere SDK has gained traction primarily because it dramatically lowers the barrier to implementing sophisticated NLP capabilities. Developers without machine learning expertise can add advanced language understanding to applications with minimal code, while still having fine-grained control over the model behavior when needed.

The API-first approach also means teams don't need to worry about infrastructure management or keeping up with the latest research advancements—Cohere handles these aspects, allowing developers to focus on their application logic.

Ideal Use Cases

Cohere SDK is excellent for:

Startups and teams without dedicated ML infrastructure

Applications that need to scale quickly without managing model deployment

Projects requiring enterprise-grade reliability and support

Multi-language applications serving global markets

Use cases where responsible AI practices are a priority

Considerations

The primary tradeoff with Cohere is that developers are depending on a third-party service rather than running models in their own infrastructure. This creates potential concerns around data privacy, service availability, and long-term pricing stability. Some developers also note that the API-based approach, while convenient, sometimes limits flexibility compared to having direct access to model internals.

4. PyTorch NLP (torchtext 3.0): The Researcher's Choice

For researchers and developers who prefer working closer to the metal, PyTorch's ecosystem continues to offer unparalleled flexibility. The overhauled torchtext 3.0 has evolved from a collection of utilities into a comprehensive NLP framework while maintaining the flexibility that PyTorch users value.

Key Features and Improvements

The latest version brings several significant upgrades:

Native Support for Transformer Architectures: First-class implementations of attention mechanisms and transformer blocks make it easier to implement custom architectures.

Optimized Data Processing Pipelines: New vectorized text processing operations leverage modern CPUs and GPUs more effectively, dramatically speeding up preprocessing steps.

Enhanced Transfer Learning Framework: The refined API makes it straightforward to adapt pre-trained models to new tasks while maintaining precise control over the training process.

Quantization and Pruning Tools: Built-in capabilities for model compression enable researchers to reduce model size and inference time without excessive performance degradation.

Improved Batch Processing: Smarter batching strategies for variable-length sequences result in more efficient GPU utilization during training.

Why Researchers and Developers Choose It

PyTorch NLP remains the preferred choice for research and specialized applications because it offers maximum flexibility without sacrificing usability. The imperative programming style aligns with how most developers think, making it easier to debug models and experiment with novel approaches.

The seamless integration with the broader PyTorch ecosystem also means that advancements in general deep learning (like optimization techniques or training methods) are immediately applicable to NLP tasks.

Ideal Use Cases

PyTorch NLP is best suited for:

Research projects exploring novel architectures or training approaches

Applications requiring customized model behavior not available in higher-level libraries

Educational contexts where understanding model internals is important

Projects where integration with computer vision or other modalities is needed

Situations requiring maximal control over the training process

Considerations

The flexibility of PyTorch NLP comes with a steeper learning curve and more implementation responsibility. Developers need to make more architectural decisions and implement more components from scratch compared to higher-level libraries. Additionally, some production optimization features require additional work to implement properly.

5. JAX NLP (FLAX/Prax): Performance at Scale

JAX has established itself as the framework of choice for training and deploying extremely large language models, and its NLP ecosystem has matured significantly. The FLAX and Prax libraries built on JAX offer unprecedented performance for large-scale NLP workloads while maintaining a reasonable developer experience.

Key Features and Improvements

JAX's NLP ecosystem offers several distinctive advantages:

Transparent XLA Compilation: Automatic optimization for TPUs, GPUs, and specialized hardware delivers remarkable training and inference speed improvements.

Functional Programming Model: The pure functional approach simplifies distribution across multiple devices and helps avoid subtle training bugs.

Advanced Parallelism: Built-in support for model, data, and pipeline parallelism makes training massive models more accessible.

Hardware-Specific Optimizations: Specialized implementations take full advantage of the latest accelerator features from different hardware vendors.

Differential Privacy Integration: Built-in support for private training methods addresses growing regulatory requirements around data privacy.

Why Teams Choose It

Organizations working with extremely large models or datasets choose JAX-based solutions primarily for the performance benefits. Models that would take weeks to train on other frameworks can often be completed in days with JAX, representing significant cost savings in cloud compute resources.

The functional approach also brings benefits for reproducibility and debugging, which become increasingly important as models grow in complexity and training runs become more expensive.

Ideal Use Cases

JAX NLP is ideal for:

Training and deploying very large language models

Organizations with access to specialized hardware (TPUs, etc.)

Projects requiring maximum computational efficiency

Situations where reproducibility is critical

Applications demanding rigorous privacy guarantees

Considerations

JAX's programming model, while powerful, represents a significant departure from the more familiar object-oriented approaches of other frameworks. This can increase the initial learning curve, particularly for developers without a strong functional programming background. Additionally, while the ecosystem is growing rapidly, it still has fewer ready-to-use components than more established frameworks.

6. TensorFlow Text 3.0: ettevõtte stabiilsus

Põhifunktsioonid ja täiustused

TensorFlow Text 3.0 pakub mitmeid olulisi täiustusi:

Integreerimine TF Extendediga: sujuv ühendus TensorFlow tootmis-ML torujuhtme tööriistadega lihtsustab teekonda katsetamisest juurutamiseni.

Täiustatud TFLite'i tugi: TFLite'i täiustatud tekstitöötlustoimingud muudavad NLP-mudelite juurutamise mobiil- ja ääreseadmetes praktilisemaks.

Järjepidev platvormideülene kogemus: samad mudelid ja töötlemiskonveierid töötavad usaldusväärselt kõigis koolitus- ja järelduskeskkondades alates pilve-TPU-dest kuni mobiilseadmeteni.

Laiendatud ettevõtte integreerimine: tavaliste ettevõtte andmeallikate omaühendused lihtsustavad tekstitöötluse kaasamist olemasolevatesse töövoogudesse.

Põhjalikud teenindusvalikud: alates TF-i teenindamisest kuni SavedModelini ja lõpetades TFLite'iga, hõlmavad juurutamisvalikud praktiliselt iga sihtkeskkonda.

Miks organisatsioonid selle valivad

TensorFlow Text on endiselt populaarne ettevõtte keskkondades, kuna see pakub terviklikku lahendust andmete ettevalmistamisest juurutamiseni. API stabiilsus ja ulatuslikud juurutusvõimalused vähendavad riski, mis on seotud NLP lisamisega missioonikriitilistesse rakendustesse.

Integreerimine Google'i pilvepakkumistega pakub ka lihtsat skaleerimist organisatsioonidele, kes on sellesse ökosüsteemi juba investeerinud.

Ideaalsed kasutusjuhtumid

TensorFlow Text 3.0 on suurepärane:

Ettevõtterakendused, mis nõuavad tootmise stabiilsust

Mobiilseadmete ja servade juurutamise stsenaariumid

Organisatsioonid, kellel on olemasolevad TensorFlow investeeringud

Projektid, mis vajavad terviklikke ML-i torujuhtmeid

Rakendused, kus juurutamise paindlikkus on hädavajalik

Kaalutlused

Kuigi TensorFlow Text jätkab uute võimaluste lisamist, jääb see viimaste teadusuuringute edusammude rakendamisel mõnikord teistest raamistikest maha. Lisaks leiavad mõned arendajad, et sümboolne programmeerimismudel on katsetamiseks vähem intuitiivne võrreldes PyTorchi hädavajaliku lähenemisviisiga.

7. Flair 2.0: NLP Šveitsi armee nuga

Põhifunktsioonid ja täiustused

Flair 2.0 toob kaasa mitmeid märkimisväärseid täiustusi:

Hübriidmanustuste raamistik: kombineerige hõlpsalt erinevat tüüpi manuseid (kontekstipõhine, staatiline, märgitasand), et saavutada konkreetsete ülesannete jaoks optimaalne jõudlus.

Ühekordsed õppimisvõimalused: uued mõne võttega õppemeetodid annavad üllatavalt häid tulemusi spetsiaalsete ülesannete puhul minimaalsete märgistatud andmetega.

Täiustatud dokumenditeave: täiustatud dokumendimodelleerimismeetodid tabavad paremini pikaajalisi sõltuvusi pikkades tekstides.

Sujuv peenhäälestus: lihtsustatud töövood eelkoolitatud mudelite kohandamiseks konkreetsete domeenide või ülesannetega.

Kergemad ressursinõuded: täiustatud tõhusus muudab Flairi sobilikuks kasutamiseks vähem võimsa riistvara puhul.

Miks arendajad selle valivad?

Flair on pälvinud pühendunud jälgijaskonna, kuna see saavutab suurepärase tasakaalu jõu ja lihtsuse vahel. Raamatukogu pakub paljude tavaliste NLP-ülesannete jaoks peaaegu tipptasemel jõudlust, nõudes samal ajal oluliselt vähem koodi ja arvutusressursse kui raskemad raamistikud.

Intuitiivne API disain muudab selle kättesaadavaks ka arendajatele, kes ei ole NLP-spetsialistid, võimaldades neil suhteliselt õrna õppimiskõveraga oma rakendustesse lisada keeruka keeleoskuse.

Ideaalsed kasutusjuhtumid

Flair 2.0 töötab kõige paremini:

Projektid, mis nõuavad suurepärast järjestuse märgistamist (NER, POS märgistamine)

Piiratud arvutusressurssidega rakendused

Meeskonnad, kes otsivad standardsete NLP-ülesannete kiiret rakendamist

Stsenaariumid minimaalsete märgistatud treeningandmetega

Spetsiaalsed tekstide klassifitseerimise rakendused

Kaalutlused

Kuigi Flair jätkab oma võimaluste laiendamist, ei paku see sama palju mudeleid ja tehnikaid kui suuremad raamistikud, nagu Hugging Face Transformers. Lisaks märgivad mõned arendajad, et kuigi selle dokumentatsioon paraneb, puuduvad siiski põhjalikud näited, mida leidub rohkem väljakujunenud teekides.

Järeldus: oma vajadustele sobiva NLP-teegi valimine

Hugging Face Transformers 6.0 pakub kõige põhjalikumat ökosüsteemi ja mudelivalikut

SpaCy 4.0 tagab tööstuslikult tugeva jõudluse ja tootmise töökindluse

Cohere SDK pakub API-põhist mugavust pidevalt uuendatavate mudelitega

PyTorch NLP annab teadlastele maksimaalse paindlikkuse ja kontrolli

JAX NLP pakub võrreldamatut jõudlust suuremahuliste rakenduste jaoks

TensorFlow Text 3.0 pakub ettevõtte stabiilsust ja juurutamisvõimalusi

Flair 2.0 ühendab muljetavaldavad võimalused kerges pakendis

Õige valik sõltub teie konkreetsetest nõudmistest:

Kiire prototüüpide loomiseks ja tipptasemel mudelitele juurdepääsu tagamiseks on Hugging Face Transformers endiselt raske ületada. Kui teie peamised mured on tootmise usaldusväärsus ja tõhusus, on SpaCy jätkuvalt suurepärane. Kui arenduskiirus ja juurutamise lihtsus on kõige olulisemad, pakub Cohere'i API-first lähenemisviis kaalukaid eeliseid.

Maksimaalset paindlikkust vajavad teadlased kalduvad endiselt PyTorchi NLP poole, samas kui organisatsioonid, kes koolitavad massiivseid mudeleid, saavad JAXi jõudluse optimeerimisest kasu. Stabiilsust ja kõikehõlmavaid juurutamisvõimalusi hindavad ettevõtted peavad TensorFlow Texti turvaliseks valikuks ning meeskonnad, kes otsivad muljetavaldavate võimalustega kerget lahendust, peaksid kaaluma Flairi kasutamist.

Kuna NLP-tehnoloogia areneb jätkuvalt märkimisväärses tempos, aitab nende raamatukogude võimaluste ja arengusuundadega kursis olemine teil teha oma projektide jaoks parima valiku ja hoida oma rakendused tipptasemel.

Mis on teie järgmine NLP-projekt ja milline neist raamatukogudest võiks teie konkreetsetele vajadustele ideaalselt sobida?